Verbalized Sampling: Mehr Vielfalt ohne Fine-Tuning

Es gibt diese seltsame Paradoxie moderner Sprachmodelle: Sie sind beeindruckend klug – und klingen trotzdem oft, als hätten sie sich auf eine einzige, „vernünftige“ Stimme geeinigt. Freundlich. Ausgewogen. Risikoarm. Und auf Dauer: vorhersehbar.

In der Forschung hat dieses Phänomen einen Namen: Mode Collapse. Gemeint ist nicht, dass ein Modell plötzlich unbrauchbar wird. Sondern dass es nach Alignment (z. B. durch RLHF) auffällig oft in denselben Antwortmodus rutscht – besonders dort, wo es eigentlich viele gleich gute Möglichkeiten gäbe: kreatives Schreiben, Dialog, offene Fragen, Ideenfindung.

Ein Paper von Oktober 2025 bringt dafür eine angenehm greifbare Erklärung ins Spiel: Typicality Bias. Wenn menschliche Preference-Daten „typische“, vertraute Formulierungen bevorzugen, lernt das Modell langfristig genau das zu belohnen: das Mittige, das Erwartbare, das bereits gut klingt. Die Ränder der Verteilung – also die spannenden Varianten – werden seltener. Das ist Alignment als kultureller Glätter. Quelle: arXiv:2510.01171

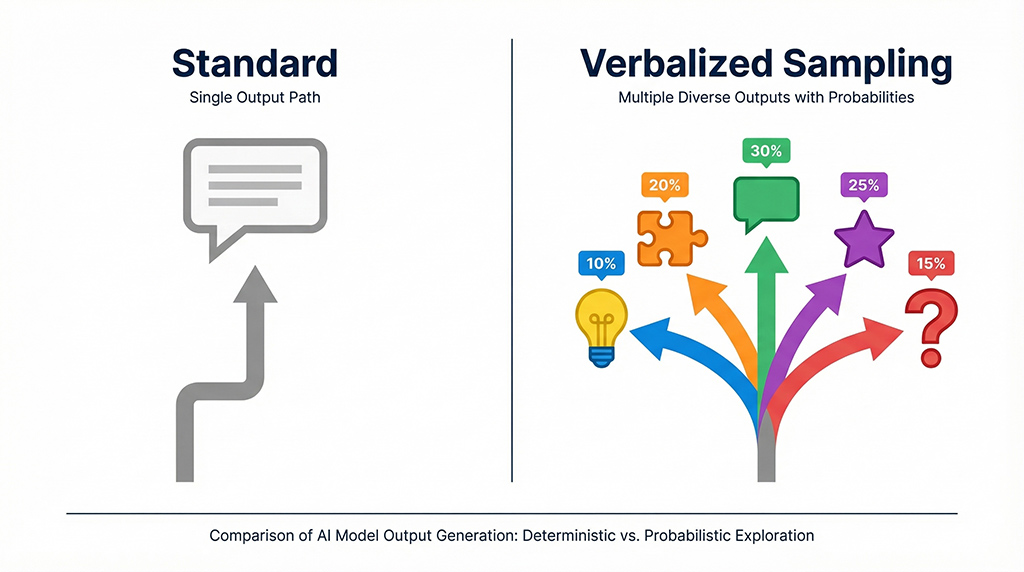

Die Idee hinter Verbalized Sampling

Die Gegenmaßnahme, die das Paper vorschlägt, ist fast irritierend simpel: Verbalized Sampling (VS) ist eine trainingfreie Prompting-Technik. Statt „Gib mir eine Antwort“ fragt man das Modell nach einer kleinen Antwortverteilung.

Der zentrale Trick: Das Modell soll nicht nur Optionen nennen, sondern sie als Wahrscheinlichkeitsraum beschreiben. Damit verschiebt sich die Aufgabe – weg vom „gib die sicherste Einzelantwort“ hin zum „zeige mir plausible Alternativen, auch weniger wahrscheinliche“.

Im Paper klingt das sinngemäß so: „Generiere 5 Antworten und ihre jeweiligen Wahrscheinlichkeiten, inklusive low-probability Varianten.“ In Experimenten steigt die Diversität bei Creative-Writing-Aufgaben laut Paper um 1,6 bis 2,1x, ohne dass Qualität und Safety leiden. Quelle: arXiv:2510.01171

Wichtig dabei: Diese „Wahrscheinlichkeiten“ sind in vielen Produkten nicht die echten Token-Probabilities, sondern eine nützliche Selbstbeschreibung. Der Wert liegt oft weniger in der numerischen Exaktheit, mehr im erzielten Perspektivwechsel.

Warum das in der Praxis funktioniert

Aus Workflow-Sicht fühlt sich VS an wie ein Hebel gegen den eingebauten „Be careful“-Reflex vieler Modelle. Du zwingst das System, mehr von dem zu zeigen, was es ohnehin weiß, aber normalerweise nicht als erste Wahl ausspielt.

Und noch ein Detail ist spannend: Das Paper berichtet einen Trend, dass fähigere Modelle stärker von VS profitieren. Das passt zur Intuition: Je größer der interne Möglichkeitsraum, desto mehr lohnt es sich, ihn überhaupt abzurufen. Quelle: arXiv:2510.01171

Drei VS-Prompts, die ich wirklich nutzen würde

1) Kreativität ohne Fluff

Du bist ein präziser, kreativer Assistent.

Erzeuge 5 unterschiedliche Antworten auf die Frage und gib zu jeder eine Wahrscheinlichkeit (Summe = 1.0).

Beziehe mindestens 2 low-probability, aber plausible Optionen ein.

Frage: Welche ungewöhnliche Eröffnung eignet sich für einen Essay über digitale Müdigkeit?2) Offene Fragen, weniger „Einheitsantwort“

Generiere 5 plausible Antworten mit Wahrscheinlichkeiten (Summe = 1.0).

Markiere Unsicherheiten explizit.

Frage: Warum scheitern viele Wissensmanagement-Tools in kleinen Teams?3) VS-CoT für schwierige Aufgaben (sparsam einsetzen)

Denke schrittweise.

Erzeuge 5 Lösungsansätze mit Wahrscheinlichkeiten.

Danach wähle einen Ansatz und liefere die finale Antwort kurz und klar.

Aufgabe: Entwirf ein Experiment, um Mode Collapse in Chatbots zu messen.(Varianten wie VS-CoT werden im Umfeld des Papers ebenfalls diskutiert, etwa über den OpenReview-Eintrag und Community-Zusammenfassungen. Quelle: OpenReview)

Grenzen und Nebenwirkungen

VS ist kein Zauberstab, sondern ein Inference-Time-Kompromiss:

- Token-Kosten: Du erzeugst mehrere Kandidaten – das kostet oft 2-5x Tokens, je nach Setting.

- Scheinpräzision: Die Zahlen sind manchmal eher „kalibriertes Storytelling“ als echte Modellwahrscheinlichkeit.

- Safety bleibt wichtig: VS soll Vielfalt heben, nicht Leitplanken aushebeln. Gute Prompts behalten klare Grenzen.

Wenn du Alternativen suchst, die weniger „Mehrfachausgabe“ brauchen, sind klassische Sampling-Parameter (top-p, temperature) oder strukturierte Mehrperspektiven-Prompts oft der nächste Schritt. VS ist besonders dann stark, wenn du spürst: „Das Modell kann mehr – es zeigt es nur nicht.“

Praktische Links zum Einstieg:

- Paper: arXiv:2510.01171

- Projektseite: verbalized-sampling.com

- Code/Material: GitHub: CHATS-lab/verbalized-sampling